Forse non tutti lo sanno ma il 2 Agosto 2025 è partita una nuova normativa Europea, l’ AI ACT EU, la prima sull’Intelligenza Artificiale, a cui tutte le aziende, senza distinzione di dimensioni e settore, dovranno uniformarsi. Inoltre è in corso di approvazione il Decreto AI Act Italiano per armonizzare le normative Italiane a questo Regolamento. Scopri in questo articolo quali sono le cose fondamentali da sapere.

Che cos’è l’Artificial Intelligence Act

L’AI Act EU è la prima pietra miliare, a livello normativo, che si pone l’obiettivo di regolamentare l’utilizzo di questa nuova quanto impattante tecnologia, che si insinuerà sempre di più nelle nostre vite, sia private che lavorative ma, che mostra anche il rovescio della medaglia con possibili risvolti etici e di sicurezza.

A CHI si applica

L’Artificial Intelligence Act non indica con precisione i soggetti interessati ma, fa distinzione fra due categorie principali: Provider e User.

I Provider sono coloro che sviluppano, modificano e distribuiscono ad altri modelli IA per il loro business.

COSA devono fare i PROVIDER

I provider, ovvero chi sviluppa e/o modifica modelli di GPAI traendone un profitti, dovranno dal 2 agosto 2025 ed entro il 2 agosto 2027, fornire:

- Documentazione tecnica sui modelli AI (architettura, addestramento, ecc.).

- Un elenco delle fonti utilizzate per l’addestramento.

- Trasparenza: istruzioni d’uso chiare, informazioni sui rischi e sui soggetti terzi coinvolti.

- Regole sui diritti d’autore (Copyright) relative ai dati di addestramento.

- Eventuale adesione ad un codice di condotta una volta che sarà approvato.

Gli User invece sono i classici utilizzatori, banalmente chiunque si avvalga di strumenti AI (es. ChatGPT o CoPilot) per ri-elaborare dati, testi, immagini etc.

COSA devono fare sia USER che PROVIDER

Dal 2 agosto 2025 tutte le aziende, sia i provider che aziende utilizzatrici di modelli GPAI, dovranno sottostare a due OBBLIGHI DI BASE che dovranno adottare entro il 2 febbraio 2026:

🧐Obbligo di TRASPARENZA: Dal 2 agosto, è obbligatorio per tutte le aziende dichiarare se si utilizzano modelli GPAI. Bisognerà dichiarare inequivocabilmente se è stata utilizzata l’AI per redigere documenti, presentazioni, report o email e indicarlo al destinatario (es. nel disclaimer delle mail o in un’informativa) oltre a fornire dettagli sull’uso dei dati per l’addestramento, le fonti, l’eventuale condivisione con terzi e i diritti sul copyright.

🧑🎓Obbligo di FORMAZIONE: questa sarà l’attività prioritaria su cui si dovranno concentrare tutte le aziende dalle multinazionali alle micro-imprese. È essenziale fornire a chiunque utilizzi modelli GPAI in azienda le conoscenze minime per un uso corretto e sicuro dell’Intelligenza Artificiale. La formazione dovrebbe essere differenziata e personalizzata in base all’utente (es. reparto commerciale, amministrativo, marketing).

✋ Attenzione: la ripubblicazione e l’eventuale commercializzazione di un modello GPAI modificato, potrebbe farvi ricadere nel perimetro di applicazione dei provider, comportando gli adempimenti previsti per questa categoria. Se poi si utilizza l’Intelligenza Artificiale nel campo della sanità si ricade nel perimetro dei sistemi ad alto rischio in quanto, si potrebbero generare dei comportamenti pericolosi per l’individuo. In tal caso, gli adempimenti da seguire e le relative tempistiche di attuazione, saranno molto più stringenti e rigorosi e che saranno più precisamente descritti nel Decreto AI di imminente pubblicazione.

Il Decreto AI Act Italia di Settembre 2025

Al momento in cui scriviamo questo articolo il primo DDL AI che riguarda l’Italia, sta venendo alla luce e sarà pubblicato a giorni sulla Gazzetta Ufficiale. Il Decreto AI Italia serve ad armonizzare la normativa Italiana vigente al Regolamento AI ACT e, di seguito anticipiamo i punti principali:

I 10 PUNTI CHIAVE del Decreto AI Act Italiano

- Deleghe al Governo, entro 12 mesi dovranno essere adottati decreti legislativi per armonizzare la normativa italiana all’AI Act e regolare l’uso dei dati e degli algoritmi per l’addestramento dei sistemi di AI;

- regime duale, AgID e ACN saranno le Autorità di competenza, previo coordinamento con la Presidenza del Consiglio, per presidiare sicurezza, qualità e trasparenza dei sistemi;

- utilizzo dell’AI per supporto a diagnosi e cure, senza sostituire la decisione umana del medico, con l’obbligo di informare adeguatamente i pazienti;

- progetti di ricerca e sperimentazioni su sistemi di AI;

- possibilità di “riuso” per finalità di ricerca/sperimentazione, essenziale per il training algoritmico;

- obbligo per il datore di lavoro (e per i professionisti vs clienti/assistiti) di informare sull’uso dell’AI, con istituzione di un Osservatorio nazionale;

- uso vietato agli under 14 in assenza di consenso dei genitori;

- diritto d’autore con riconoscimento della protezione delle opere generate dall’AI se opera dell’ingegno umano, con limitazioni per l’estrazione/riproduzione da dataset coperti da diritti;

- nuovo reato di illecita diffusione di contenuti generati o manipolati dall’AI (con pene da 1 a 5 anni di reclusione);

- un miliardo di euro tramite Cdp Venture Capital per sostenere PMI e imprese innovative attive in AI, cyber sicurezza, quantistica e TIC.

I PRIMI PASSI per adeguarsi all’AI ACT

Allinearsi al Regolamento per ridurre i rischi AI e non incorrere in sanzioni non è un processo organizzativo complesso, sempre che non si è nel perimetro dei fornitori o provider di modelli AI o se non si eseguono trattamenti dati AI ad alto rischio.

Il punto di partenza sarà sicuramente un’analisi interna per stabilire quali sono le esigenze di utilizzo di strumenti GPAI in azienda. Questo serve anche per focalizzare meglio le attività formative fondamentali individuando: reparti, funzioni, utenti, responsabilità e mansioni, piattaforme e fornitori AI, in base a criteri di conformità, sicurezza, costi e prestazioni.

Altra attività strategica è stabilire un piano d’azione che includa oltre all’analisi preliminare, azioni di governance e monitoraggio continuo, tramite attività di test, auditing, documentazione e procedure che devono essere costantemente aggiornate. L’approccio da adottare può essere molto simile a quello previsto nel GDPR ovvero By Design e By Default.

🧑🎓FORMAZIONE e ALFABETIZZAZIONE: i cardini di una perfetta compliance!

La formazione e l’alfabetizzazione, una volta definite le esigenze emerse dall’analisi, devono costituire l’ossatura principale del piano d’azione, e devono coinvolgere tutti gli utenti o probabili utenti AI, a partire dai vertici aziendali.

L’obiettivo è informare, istruire e consapevolizzare sui rischi dell’Intelligenza Artificiale e sulle best-practices per sfruttarla al meglio senza mettere repentaglio i dati critici per l’azienda o dati personali e sensibili.

Anche il più “insospettabile” in azienda potrebbe essere tentato di “buttare” su ChatGPT il testo di una mail da inviare al fornitore oppure, per farsi aiutare a fare la relazione per il CDA, magari con tanto di informazioni e dati anche molto riservati e strategici.

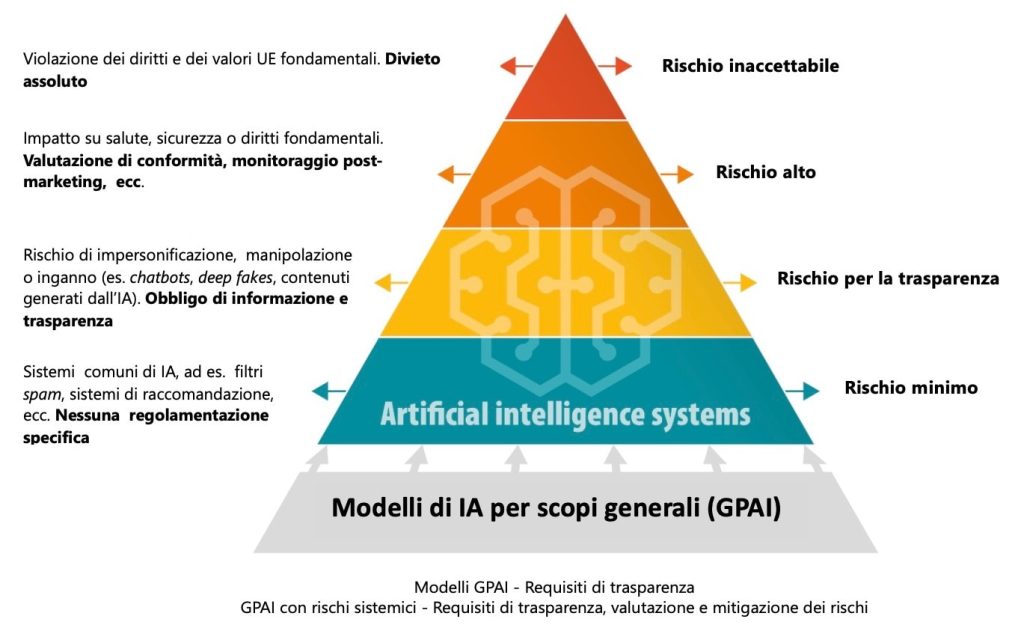

Tutto questo dovrà essere in funzione dei livelli di rischio in cui ricadono i sistemi che vengono utilizzati in azienda, in funzione dei quali si dovranno adottare piani di azione e misure organizzative differenti.

AI ACT LIVELLI di RISCHIO

È cruciale mappare i modelli di AI ad ALTO RISCHIO, suddivisi dal Regolamento AI ACT in 6 categorie:

Cosa significa GPAI

I modelli GPAI, ovvero quelli strumenti classificati a basso livello di rischio, devono comunque rispettare i più basilari principi di trasparenza, valutazione e mitigazione e sono sicuramente i più conosciuti ed utilizzati.

🤓 Alzi la mano chi non ha mai avuto la tentazione di utilizzare CHAPT GPT per rendere più “bellina” la mail da inviare al capo o al proprio miglior cliente?

L’AI ACT definisce un sistema GPAI o General Purpose Artificial Intelligence come: “Un modello di intelligenza artificiale che può essere utilizzato per una vasta gamma di compiti, non specificamente progettato o limitato a un’applicazione particolare.“

Il GPAI è uno strumento AI di base, utilizzabile così com’è da un utente finale per creare testi, immagini, video, report, presentazioni, traduzioni, ecc.

Quale IMPATTO avrà l’Artificial Intelligence Act sulle PMI e MICRO IMPRESE Italiane

Purtroppo non è ancora chiaro ai più cosa l’AI comporta in termini di rischi per la sicurezza e l’etica.

Questa norma che, ricordiamo, è la prima specifica sull’AI, ha l’obiettivo di evitare usi indiscriminati e inconsapevoli oltre a porre limiti e perimetri ben precisi per chi fonda il proprio business su questa tecnologia.

L’AI Act è un tassello normativo fondamentale che riguarda tutte le organizzazioni private e pubbliche, senza limiti di dimensione e settore!

Va da sé quindi che, anche PMI e micro-imprese, dovranno adeguarsi in maniera proporzionata all’effettivo utilizzo ed all’impatto dell’IA sul business dell’azienda.

Sarebbe un grave errore sottovalutare i pericoli che l’IA potrebbe riservare ad un’azienda solo perché di piccole dimensioni o operante in un settore no-profit (es. Onlus) quindi, ben vengano regolamentazioni ad hoc che mirino a mettere in condizione le aziende di cavalcare l’innovazione dribblando i rischi che si annidano nelle nuove tecnologie, sempre più numerose ed impattanti.

Vuoi approfondire gli argomenti trattati con i ns consulenti?